[활동3] 안전하고 투명한 인공지능

안전하고 투명한 인공지능

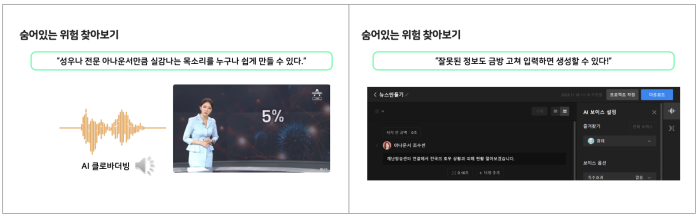

오늘 우리는 직접 인공지능을 활용해 음성을 만들었습니다. 이렇게 편리하고 쉽게 사용할 수 있는 인공지능 서비스의 장점 뒤에 어떤 위험이 숨어있는지 알아봅시다. 먼저, 조수빈 아나운서의 실제 음성과 같은 내용을 클로바 더빙으로 생성한 음성을 듣고 비교해봅시다.

“텅 비었습니다. 광화문 네거리도 해수욕장도 야구장도 음식점도 이렇게 텅 비었습니다. 코로나19가 대한민국을 마비시켰지만 저는 이 텅 빈 풍경에서 두려움 너머 시민의식을 봅니다.”

성우나 전문 아나운서만큼 실감 나고 생생한 목소리를 이렇게 누구나 쉽게 만들 수 있습니다. 앞서 활동에서 만들어 본 것처럼 말할 내용을 바꾸거나 입력하는 것도 어렵지 않습니다. 이런 장점 뒤에는 어떤 위험이 있을까요?

또한, 방송부 대본을 입력할 때 잘못된 음성이 생성된 적이 있더라도, 우리는 금방 수정하여 교내 방송을 만들 수 있었습니다. 잘못된 음성을 수정하는 방법이 쉽고 간단했기 때문입니다. 마찬가지로, 이러한 편리함 뒤에는 어떤 위험이 있을까요? 누구나 손쉽게 실감 나는 목소리로 사실과 다른 정보를 담은 음성도 금방 만들어 낼 수 있는 것은 아닐까요?

[관련 자료]

- (영상) 채널A뉴스: https://youtu.be/hE3SUzl1_lI?si=Cw8bLeWwZg0uP82G (0:20까지 시청)

[수업 지도 TIP]

1) 뉴스 영상의 20초까지 시청하며, 같은 내용으로 생성된 음성을 비교할 수 있다. 실제 아나운서의 음성은 톤과 어투의 차이가 있으나 생성된 음성과 음색이 매우 닮아있다. 차이점을 찾는 것이 목표가 아니라, 같은 음성의 목소리를 금방 생성해낼 수 있음에 주목하여 그 위험성을 생각해보도록 한다.

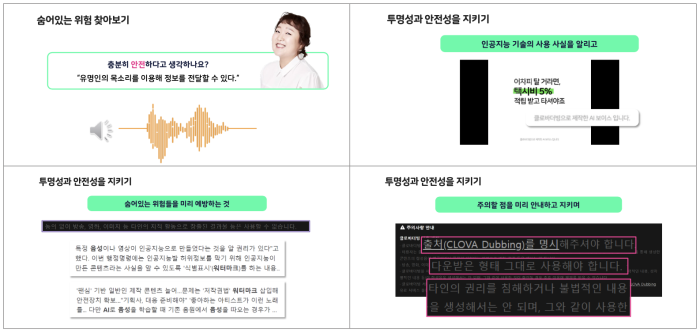

마지막으로 생성형 인공지능의 투명성과 안전성을 지키기 위한 방법을 정리해봅시다.

먼저, 생성형 인공지능 개발자는 사용자를 위해서 인공지능 기술을 사용할 때의 주의점을 알려야 합니다. 또한, 개발 과정에서 어떤 데이터를 활용하였는지 그리고 어떤 범위까지 활용할 수 있는지 설명하여야 합니다. 이를 통해 생성형 인공지능 활용 과정에서 예상되는 위험을 파악하고 예방하기 위한 노력을 이어나갈 수 있습니다.

사용자는 생성형 인공지능을 사용하기 전에 사용 방법과 주의 사항을 언제나 확인하고 올바른 용도로 쓰이도록 노력해야 합니다. 또한, 생성형 인공지능으로 창작물을 만들었다면, 인공지능으로 생성한 음성이나 영상, 이미지에 인공지능 기술을 사용했다는 사실을 안내해야 합니다. 언제나 잊지 말아야 할 것은 인공지능을 활용한 생성 결과가 다른 사람의 권리를 침해하거나 문제가 되지 않는지 살펴보는 태도입니다.

[관련 자료]

- (기사) 임재범이 하입보이를?…’AI 커버곡'열풍(https://v.daum.net/v/20231124070030193)

- (기사) ‘AI 딥페이크영상 워터마크 의무화’ 정보통신망법 일부개정법률안 발의(https://www.sentv.co.kr/news/view/676350)

[수업 지도 TIP]

1)제시된 안내 문구는 클로바 더빙 웹사이트 하단에서 학생들이 직접 찾아볼 수 있다.

2) 수업에서 생성한 음성을 활용할 때 주의할 점을 스스로 생각해보도록 지도할 수 있다.